Have any questions?

+44 1234 567 890

cerence Oktober 2022

CERENCE CONTROL CENTER

Wie natürlicher und empathischer Sprachdialog mit digitalen Avataren möglich wird

Im Rahmen des EMMI-Projekts wurde von Cerence ein Control Center erstellt, welches alle Softwarekomponenten, die von Cerence bereitgestellt werden, vereint. Diese Zentrale bezeichnen wir als das Cerence Control Center (CCC). Das CCC stellt die folgenden fünf zentralen Funktionen bereit:

- Transkription von gesprochener Sprache, Automatic Speech Recognition (ASR)

- Analyse und Interpretation der erkannten Worte, Natural Language Understanding (NLU)

- Erkennung und Interpretation der paralinguistischen Information in der Sprache und des emotionalen Zustands von Nutzern (EMO)

- Erstellung und Steuerung eines Dialogs mit dem Nutzer (Dialog Manager)

- Die synthetische Erzeugung von gesprochener Sprache, Text-To-Speech (TTS)

Das Schaubild zeigt das Zusammenspiel der einzelnen Komponenten und verdeutlicht die einzelnen Schritte, welche nötig sind, um einen empathischen, digitalen Gesprächspartner bereitzustellen.

Um die Komponenten flexibel miteinander zu verbinden und Informationen auch zwischen den Projektpartnern zugänglich und austauschbar zu machen, musste eine Kommunikationsschnittstelle definiert und implementiert werden. Über diese können die Partner Charamel, DFKI, und CanControls relevante Zwischenergebnisse des Sprachdialogsystems abrufen und eigenständig weiterverarbeiten. Das verwendete Websocket-Protokoll hat den Vorteil, dass jede Komponente im EMMI-Projekt dieselbe Kommunikationsschnittstelle verwendet und somit eine reibungslose Kommunikation zwischen den Komponenten und Partnern ermöglicht wird.

Transkription von gesprochenem Wort, Automatic Speech Recognition (ASR)

Die erste essentielle Funktion ist die Erkennung der Sprache der Nutzer. Diese Funktion wird als Spracherkennung oder kurz ASR (Automatic Speech Recognition) bezeichnet. Die Spracherkennungs-komponente im CCC greift das Audiosignal vom Mikrofon ab, extrahiert die gesprochene Sprache und wandelt sie in Text um. Dazu werden im Hintergrund sprachspezifische Modelle benutzt.

Die Integration der Spracherkennung im CCC wurde so umgesetzt, dass das Mikrofon immer aktiviert ist. Ein Dialog kann vom Benutzer mit einem beliebigen Wake-Up-Word (WuW) initiiert werden. Das System hört also kontinuierlich, ob eine als WuW definierte Phrase gesprochen wird und interpretiert dann die darauffolgenden Worte als Eingabe an das System. Zusätzlich ist das kontinuierliche Zuhören für die Emotionserkennungskomponente wichtig. So ist es möglich, aus dem eingehenden Audiosignal eine Emotion abzuleiten auch wenn kein Sprachbefehl gesprochen wurde. Aber mehr dazu später.

Analyse und Interpretation der gesprochenen Worte, Natural Language Understanding (NLU)

Im zweiten Schritt wird das Ergebnis der Spracherkennung an ein NLU-Modul übergeben. Dieses analysiert die gesprochenen Worte und eine semantische Repräsentation wird aus dem Text gewonnen. So können z.B. Füllwörter herausgefiltert und Umschreibungen für Kommandos auf eine zentrale Nutzerabsicht vereinheitlicht werden. Zum Beispiel kann man so die Anweisungen „Fahre mich bitte nach Köln“ und „Ich hätte gerne eine Navigation nach Köln“ auf denselben „Intent“ vereinheitlichen. Das macht die Weiterverarbeitung leichter, da nicht mehr auf unterschiedliche Formulierungen geachtet werden muss, sondern nur noch der Wunsch des Nutzers verwendet wird.

Erkennung und Interpretation von Paralinguistischen Informationen und emotionaler Zustand von Nutzern

Die Komponente zur Paralinguistik- bzw. Emotions-Zustandsanalyse des Cerence Control Centers bietet die Möglichkeit durch sprachbasierte Analyse Emotionen und andere paralinguistische Charakteristika (sogenannte Traits) in der Stimme des Sprechenden zu erkennen. Dabei werden im Hintergrund verschiedene Stimmeigenschaften mit speziell trainierten, wahrscheinlichkeitsbasierten Modellen verglichen, um damit kontinuierlich eine Entscheidung über den aktuellen Zustand zu treffen. Die dargestellten Werte sind nicht nur innerhalb des CCC verfügbar, sondern auch über die EMMI-Websocket-Schnittstelle abrufbar, sodass Informationen nach Bedarf an andere Systeme weitergegeben werden können.

Es wurde darauf geachtet eine flexible Architektur zu verwenden. So wurde zum Beispiel eine Funktionalität entwickelt, die es dem Nutzenden erlaubt, die Anzahl der Erkennungen pro Sekunde frei einzustellen. Dies ist vor allem hilfreich, um Forschung im Bereich Emotionszeitfenster zu machen. Dies kann uns wertvolle Erkenntnisse liefern, welche Länge ein Audiofenster haben soll, um eine Emotion robust und zuverlässig zu erkennen.

Erstellung und Steuerung eines Dialogs mit dem Nutzer (Dialog Manager)

Um eine empathische Interaktion mit dem Nutzer zu ermöglichen und dem Nutzer die gewünschten Informationen bereitzustellen wird ein Dialog-Manager benötigt. Dieser erhält die erkannten „Intents“ der NLU-Komponente und entscheidet, basierend auf diesen, wie der Dialog mit dem Nutzer fortgeführt werden soll. Diese Optionen können mit dem im CCC integrierten Dialog Manager einfach eingepflegt und erweitert werden. Er unterstützt nicht nur direkte Antworten sondern auch komplexere Subdialoge und kann über eine Netzwerkschnittstelle jegliche verbundenen Systeme kontrollieren. So könnte zum Beispiel das Fenster des Fahrzeugs geöffnet werden, um Frischluft ins Fahrzeug zu leiten oder die Lichtstimmung so angepasst werden, dass eine beruhigende Wirkung auf den Fahrer erzeugt wird.

Der Dialog Manager bildet somit die Grundlage für eine intelligente Gesprächsführung und ist gleichzeitig die Schnittstelle zu allen weiteren verbundenen Systeme, welche sowohl Daten an den Dialog Manager liefern als auch die vom Nutzer gewünschten Aktionen ausführen.

Die synthetische Erzeugung von gesprochener Sprache, Text-To-Speech (TTS)

In der Text-To-Speech Komponente kann man durch die Cerence TTS Engine Worte oder Sätze, welche im Textfeld eingegeben wurden, als Computer-generierte Sprache ausgeben. Man kann zusätzlich die Lautstärke, Geschwindigkeit, Pitch und Klangbild der generierten Sprache nach den Wünschen des Nutzers anpassen. Dies ist wichtig, da das Klangbild einen großen Einfluss auf die wahrgenommene Empathie des digitalen Dialogpartners hat. Außerdem ist es möglich, die Sprache in Deutsch und Englisch generieren zu lassen. Diese Funktionen sind ebenfalls über die EMMI-Websocket-Schnittstelle aufrufbar.

In Zusammenarbeit mit dem Konsortialpartner Charamel wurde beschlossen, dass die Erstellung von computergenerierten Audiodateien als Service erfolgen soll, das heißt er kann einfach abgefragt werden und liefert die Ergebnisse zurück. Dabei wird nicht nur das reine Audiosignal erzeugt, sondern auch Lipsync Informationen damit ein digitaler Avatar seine Lippen synchron zur Sprache bewegen kann.

Cerence Control Center – Ein Sprachinteraktionssystem zur empatischen Mensch-Maschiene Interaktion

Sprachinteraktionssysteme gibt es schon seit einiger Zeit und haben sich als erfolgreiche Mensch-Computer Schnittstelle erwiesen. Sie sind eine großartige Möglichkeit, mit komplexen technischen Systemen auf eine natürliche und menschliche Art und Weise zu interagieren, aber es gibt noch einige Herausforderungen, die angegangen werden müssen.

Eines der Probleme ist die Emotionalität sowohl in der Sprachausgabe, innerhalb des Dialogs, als auch die Erkennung der Nutzeremotion welche großen Einfluss auf das vertrauen gegenüber einem System hat. Hier kommt das CCC als Lösung ins Spiel. Es ist ein flexibles Toolkit, das tiefe neuronale Netze verwendet, um die gesprochene Sprache zu erkennen, Emotionen zu detektieren, und entsprechend darauf zu reagieren.

Das CCC ist ein Sprachinteraktionssystem, dass es uns und unseren Projektpartnern ermöglicht, auf empathische Weise mit Maschinen zu interagieren. Es bildet einen Baukasten welcher alle relevante Zwischenergebnisse bereitstellt, die wiederum von den Partnern verwendet werden können, um ihre eigenen Sprachinteraktionssystem zu erstellen und zu verbessern. Alles mit dem Ziel sich in den Benutzer einfühlen zu können und so Vertrauen zu schaffen und die Interaktion natürlich und intuitiv zu gestalten.

ika, CanControls September 2021

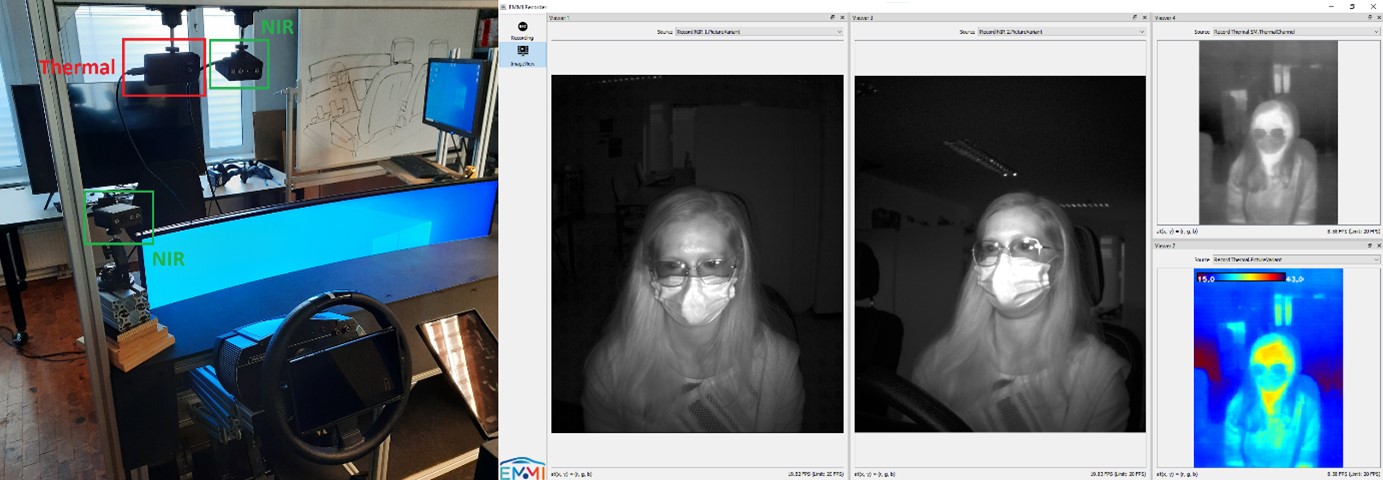

Im September 2021 wurde unsere EMMI interior vehicle mock-up aufgebaut und auf der Interior Vehicle Tagung vorgestellt. Der modulare Aufbau hat in dieser Konfiguration drei integrierte Displays. Durch die Modularität des Aufbaus können aber jederzeit andere Konfigurationen eingesetzt und getestete werden. Auch die Hardware der EMMI-Partner wurde bereits in dem interior vehicle mock-up verbaut. Zur Emotionserkennung werden nun Studien mit Testpersonen mit dem Aufbau durchgeführt und Daten gesammelt.

ika Dezember 2021

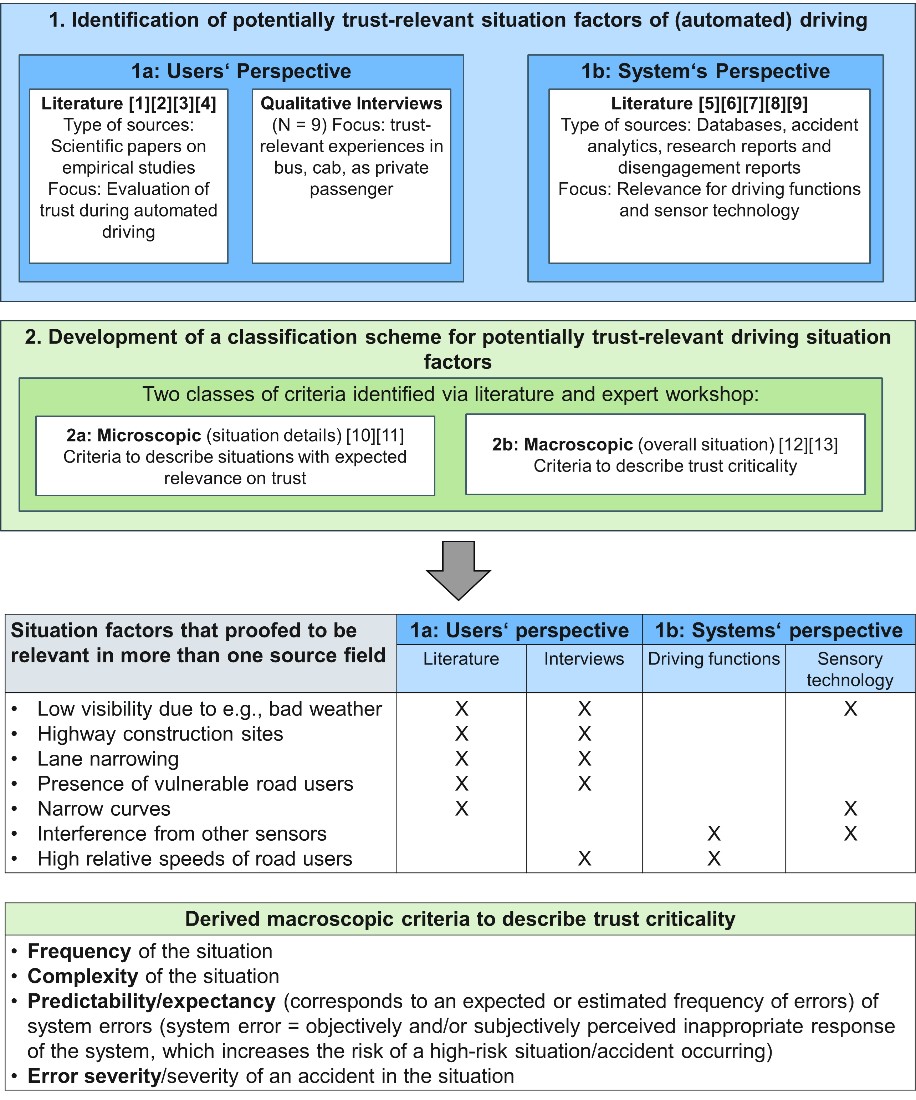

Paper veröffentlicht! Im Rahmen des Papers werden die weniger häufig untersuchten externen Situationsfaktoren untersucht. Um potenziell vertrauensrelevante Situationsfaktoren besser zu verstehen, zu beschreiben und hinsichtlich ihrer Kritikalität für Vertrauen zu klassifizieren, wurden Literaturrecherchen, Interviews sowie ein Expertenworkshop durchgeführt. Das Ergebnis ist eine strukturierte Auflistung von potenziell vertrauensrelevanten, treibenden Situationsfaktoren sowie Kriterien für die makro- und mikroskopische Beschreibung dieser Situationen und Situationsfaktoren. Die im Rahmen der vorliegenden Arbeit theoretisch abgeleiteten potenziell vertrauensrelevanten Situationsfaktoren und Kriterien werden im Rahmen einer geplanten On-Road-Studie verifiziert und ggf. erweitert.

Link zum Paper hier

ika Januar 2022

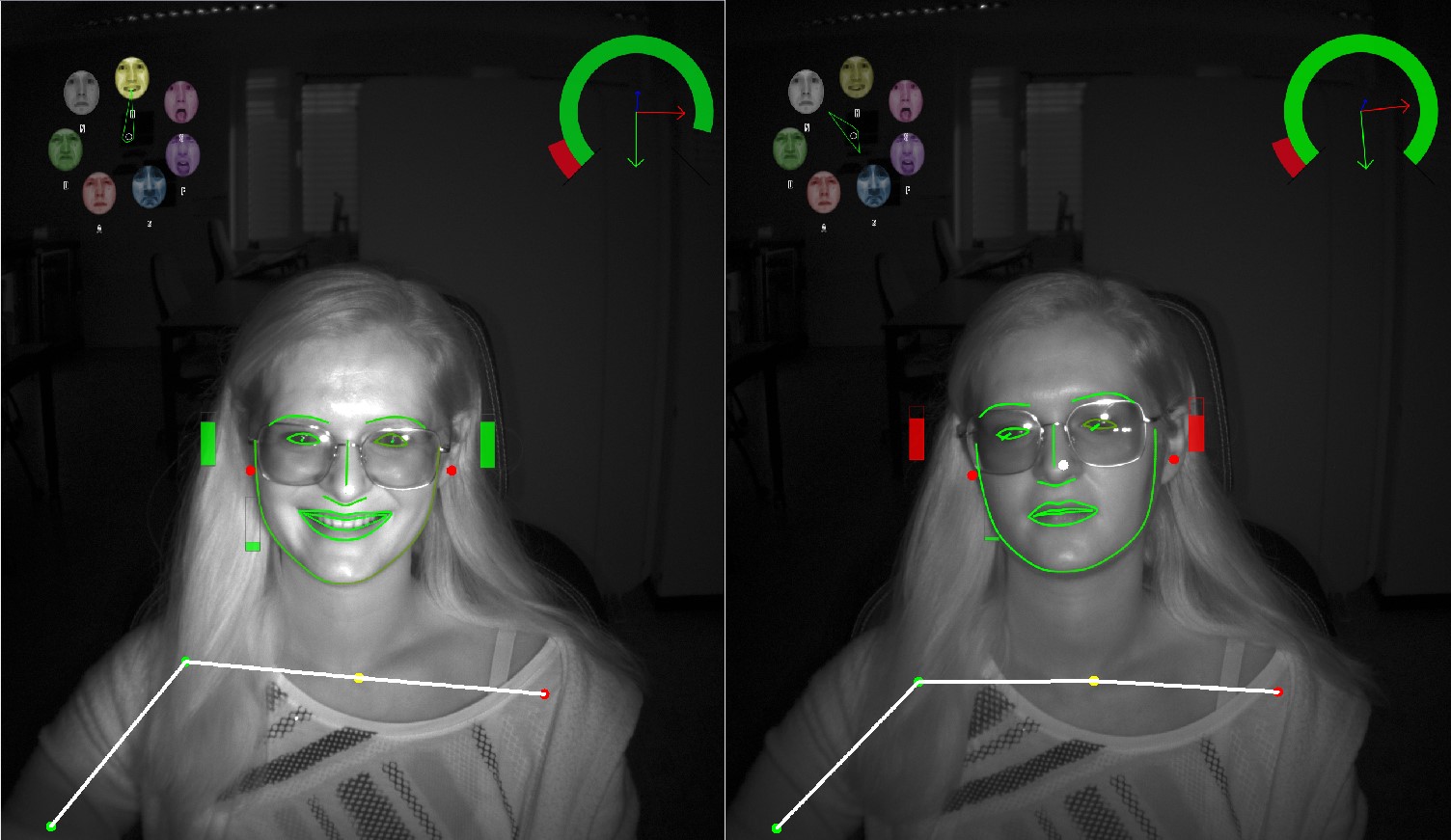

Für viele zukünftige Nutzer*innen ist die Vorstellung beängstigend, sich der Automation auszusetzen, ohne Einfluss auf das Fahrverhalten des Fahrzeuges nehmen zu können. Das möchten wir in EMMI ändern. Ein Lösungsansatz des EMMI-Projektes zur Steigerung des Vertrauens in das automatisierte Fahrzeug ist es, die automatisierte Fahrt beeinflussbar zu machen. Dafür haben wir ein Gestenkonzept entwickelt, mit dem Anpassungen der automatisierten Fahrt kommuniziert werden können. So kann bspw. der Abstand zum Vordermann, das Beschleunigungsverhalten oder die Position innerhalb der eigenen Spur verändert werden. Das Gestenkonzept basiert dabei auf einfacher Sensorik in Form von RGB-Kameras. Zusätzlich wird die Blickrichtung analysiert, um die detektierte Geste einem konkreten Nutzerwunsch zuzuordnen.

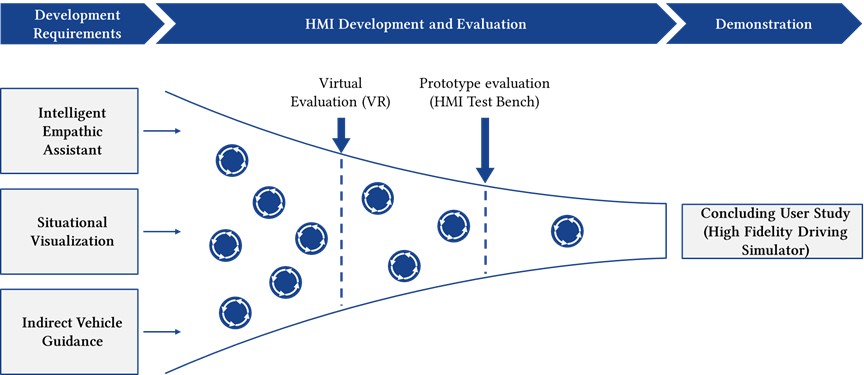

ika, DFKI, cerence, CanControls, Charamel, Saint-Gobain Sekurit April 2022

Paper veröffentlicht! Um die Idee und die Lösungsansätze des Projektes weiter zu verbreiten und dem interessierten Fachpublikum zur Verfügung zu stellen, hat das Konsortium gemeinsam ein wissenschaftliches Übersichtspaper über das Gesamtprojekt verfasst. Das Paper beschreibt die einzelnen Lösungsbausteine, welche den potenziellen Nutzern zukünftiger automatisierter Fahrzeuge helfen sollen, das Systemverhalten besser zu verstehen und ihrem Fahrzeug somit vertrauen zu können. Auch die psychologischen Grundlagen der hybriden Vertrauensmodellierung werden in dem Paper beschrieben. Selbstverständlich ist das Paper freizugänglich, ihr findet es auch auf der Downloadseite direkt hier auf der Homepage! Lest es euch gerne durch!

EMMI-Roadmap:

ika, CanControls Juli 2022

Unser EMMI-Versuchsfahrzeug ist fertig foliert und wurde auf der IEEE Intelligent Vehicles im Juli 2022 vorgestellt. Ende des Jahres werden wir damit Probandenstudien durchführen, um das Vertrauen in die automatisierte Fahrt in speziellen Situationen zu untersuchen. Auch die Hard- und Software unserer Partner wurde im Forschungsfahrzeug verbaut. Mit dem Softwaretool von CanControls werden wir Blickverhalten, Herzrate und Audioaufzeichnungen im Fahrzeug durchführen. Wir freuen uns, dass das Fahrzeug jetzt auf der Straße unterwegs ist. Haltet die Augen danach offen!

ika Juli 2022

DOI http://doi.org/10.54941/ahfe1002462

In diesem Paper beschreiben wir unseren Entwurf eines theoretischen Rahmenmodells zum Zusammenhang der Konstrukte Vertrauen in die Automatisierung (TiA) und Technologieakzeptanz unter Berücksichtigung der Einflussfaktoren von TiA für den Anwendungskontext des automatisierten Fahrens. Der Einfluss von Vertrauen auf die Akzeptanz von automatisierten Systemen scheint empirisch belegt zu sein. Dennoch vernachlässigen Akzeptanzmodelle häufig das Konzept des Vertrauens oder die Einflussfaktoren des Vertrauens. Um eine ganzheitlichere Perspektive auf den Zusammenhang zu erhalten, haben wir eine strukturierte Literaturanalyse durchgeführt. Berücksichtigt wurden wissenschaftliche Arbeiten, die den Zusammenhang zwischen TiA und Akzeptanz sowie Einflussfaktoren auf das Vertrauen im Kontext des automatisierten Fahrens betrachten.

ika Oktober 2022

VR-Umgebung

Im Rahmen des EMMI-Projektes wurde am ika eine virtuelle Umgebung mit der Entwicklungsumgebung Unity erschaffen, in der frühzeitig HMI-Konzepte umgesetzt und evaluiert werden können. Darin wird eine automatisierte Fahrt abgebildet, die einige vertrauenskritische Situationen beinhaltet, wie beispielsweise Personen auf der Fahrbahn oder Kreuzungssituationen. Diese Fahrt kann entweder in Virtueller Realität mit einer VR-Brille oder in der für das Projekt konstruierte interior vehicle mock-up erlebt werden. In einer Expertenstudie wird getestet, ob die Situationen in VR oder in dem interior vehicle mock-up als vertrauenskritischer wahrgenommen werden. Zusätzlich wird nach Visualisierungen gefragt, die das Vertrauen in die Automation steigern könnten. Anschließend werden die Konzepte zur Beeinflussung des Vertrauens in die Automation in der virtuellen Umgebung umgesetzt und auf ihre Wirksamkeit getestet.